Projektöversikt

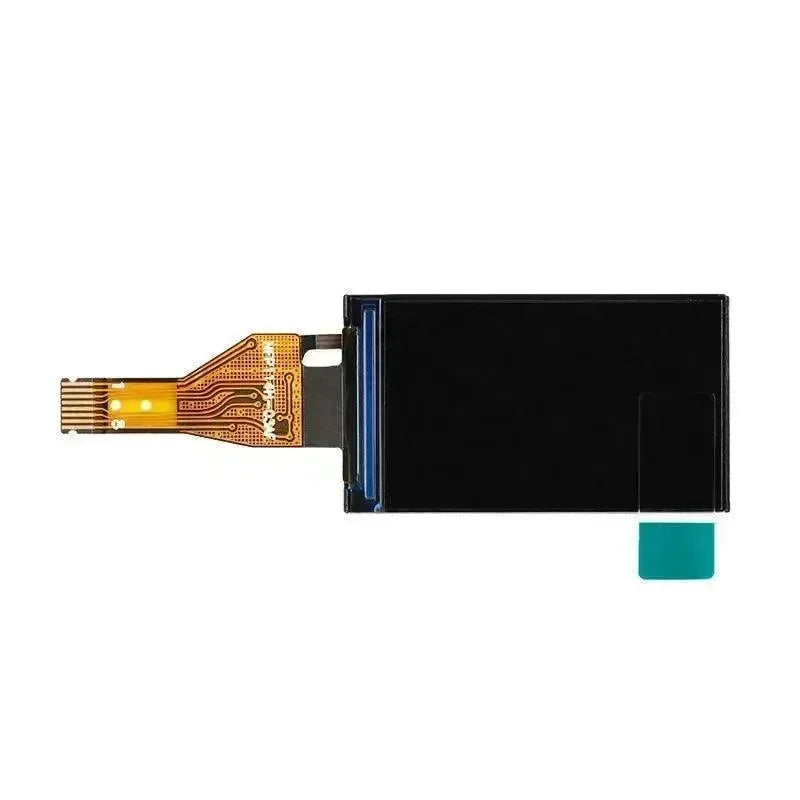

Fallavkänning är en viktig teknik, särskilt inom äldreomsorg och smarta hemsäkerhetssystem. Med Raspberry Pi och OpenCV kan du bygga ett effektivt detekteringssystem som övervakar fall i realtid och loggar data. Detta projekt är en förbättrad version av KNN 3D Human Skeleton Recognition-projektet, designat för att vara praktiskt och lätt att implementera.

Hej 👋! Välkommen till OpenELAB’s handledningsprojekt! Den här artikeln ger en detaljerad guide om hur man använder en Raspberry Pi 4B och OpenCV för att implementera ett system för att upptäcka när människor faller. Handledningen är uppdelad i tre delar, och idag fokuserar vi på Del 2, där vi implementerar kärnfunktionaliteten. Detta inkluderar:

-

Tränar datan

-

Sparar resultaten i en CSV fil

-

Använda en kamera för att validera din modell

Låt oss dyka in och bygga något fantastiskt tillsammans! 🚀

Nästa kommer vi att guida dig steg för steg 📜 genom källkod, vilket gör det enkelt för dig att dyka in i detta projekt!

Är du redo? Låt oss börja 🚀

Steg att följa

-

🚀 Öppna Remote

-

Ställ in kameran

-

Konfigurera VSCode

-

Kör projektet i VSCode

-

🔧 Följ bruksanvisningen

Notera: Detta projekt är en modifierad version av KNN 3D Human Skeleton Recognition-projektet. Det ger en komplett handledning för att köra det smidigt på en Raspberry Pi.

Handlingsplan

Öppna fjärrkontroll:

Steg för att öppna kameran:

IDE Python-körplats på Raspberry Pi:

Konfigurationskod: Fördelar, enklare felsökning:

Öppningsprocess:

Installation lyckades: Kör test.py

Kompilera och kör

-

Först, kör testkoden test.py för att säkerställa att kameran fungerar korrekt.

-

Kör First_train.py-filen för att träna data och spara de mänskliga kroppens nyckelpunkter som 1_Fall.csv och 2_Normal.csv-filer. Användaren kan trycka på Esc-tangenten för att avsluta och spara resultaten.

-

Kör second_KNN.py-filen för att använda KNN-modellen för konfiguration.

-

Kör Third.py-filen för verifiering. Du kan ladda upp en video med kompletta mänskliga nyckelpunkter eller öppna din kamera för testning.

Slutresultat (inkluderar GIF-filer)

Referenslänkar:

openelab.de

openelab.de

openelab.com

openelab.com