Was ist TensorFlow Lite?

TensorFlow Lite ist eine leichtgewichtige Version von TensorFlow, die für mobile und eingebettete Geräte wie ESP32 entwickelt wurde und es ermöglicht, maschinelle Lernmodelle auf hardwarebeschränkten Geräten auszuführen.

Schritte zur Bereitstellung auf ESP32

So bringen Sie ein Machine-Learning-Modell auf Ihrem ESP32 zum Laufen:

Trainieren eines Modells

Trainiere ein einfaches neuronales Netzwerk, zum Beispiel zur Vorhersage von Sinuswerten, mit Python und Keras auf deinem PC. Installiere TensorFlow mit:

-

Befehl: pip install tensorflow

-

Beispielcode:

importiere Numpy als np importiere tensorflow als tf von tensorflow import keras Winkel = np.random.uniform(low=-np.pi, high=np.pi, size=(1000, 1)) sines = np.sin(winkel) model = keras.Sequential([keras.layers.Dense(1, input_shape=(1,))]) model.compile(optimizer='adam', loss='mean_squared_error') model.fit(winkel, sinuswerte, epochen=100, ausgabe=0) model.save('sine_model.h5')✔ Kopiert!

In TensorFlow Lite konvertieren

Konvertieren Sie das trainierte Modell in das .tflite-Format:

-

Installationswerkzeug: pip install tflite

-

Konvertieren: tflite_convert --keras_model_file sine_model.h5 --output_file sine_model.tflite

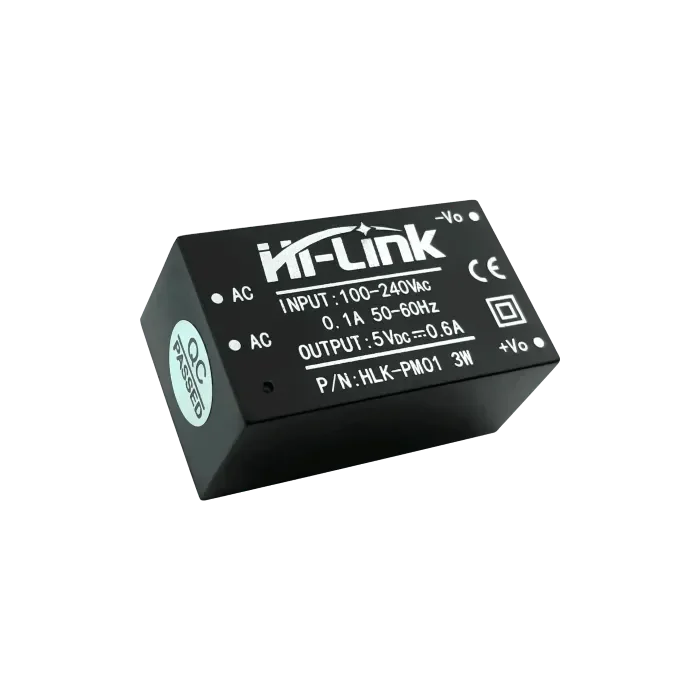

ESP32 einrichten

Verwenden Sie die Arduino IDE für die ESP32-Entwicklung. Installieren Sie die ESP32-Unterstützung:

-

URL hinzufügen: http://dl.espressif.com/dl/package_esp32_index.json in den Einstellungen.

-

Über den Board-Manager installieren.

-

Fügen Sie die tflite-micro-Bibliothek aus dem GitHub-Repository zu den Arduino-Bibliotheken hinzu.

Integrieren und ausführen

Konvertieren Sie .tflite in ein C-Array: xxd -i sine_model.tflite > sine_model.h. Verwenden Sie diesen Arduino-Sketch:

-

Code:

#include #include "tflite-micro.h" #include "sine_model.h" tflite::MicroErrorReporter micro_error_reporter; tflite::ErrorReporter* error_reporter = µ_error_reporter; const unsigned char* model_data = sine_model; const size_t model_size = sine_model_len; const tflite::Model* modell = tflite::GetModel(model_daten); tflite::AllOpsResolver resolver; constexpr int kTensorArenaSize = 2000; uint8_t tensor_arena[kTensorArenaSize]; tflite::MicroInterpreter Interpreter(Modell, Resolver, Tensor_Arena, kTensorArenaSize, Fehlerbericht) ; float zufälligeGleitkommazahl(float min, float max) { return min + (max - min) * (float)random(0, 10000) / 10000.0; } void setup() { Serial.begin(115200); interpreter.AllocateTensors(); } void-Schleife() { float winkel = randomFloat(-3.1416, 3.1416); TfLiteTensor* Eingabe = interpreter.input(0); input->data.f[0] = Winkel; if (interpreter.Invoke() != kTfLiteOk) { error_reporter->Report("Modell konnte nicht aufgerufen werden"); zurückkehren; } TfLiteTensor* Ausgabe = interpreter.output(0); float Vorhersage = output->data.f[0]; Serial.print("Winkel: "); Serial.print(Winkel); Serial.print(", Vorhergesagte Sinuskurve: "); Serial.println(Vorhersage); Verzögerung (1000); }✔ Kopiert!

-

Auf ESP32 hochladen, Serial Monitor öffnen, um Ergebnisse zu sehen.

Unerwartetes Detail

Man würde vielleicht nicht erwarten, dass die Zufalls-Gleitkommazahl-Funktion eine einfache Skalierung von random(0, 10000) verwendet, was für ML möglicherweise nicht die präziseste Methode ist, aber für dieses Beispiel funktioniert.

TensorFlow Lite auf ESP32 bereitstellen

Diese umfassende Analyse untersucht den Einsatz von TensorFlow Lite auf dem ESP32-Mikrocontroller und beschreibt den Prozess vom Modelltraining bis zur Ausführung, basierend auf Forschung und praktischer Umsetzung. Der Schwerpunkt liegt darauf, Entwicklern eine gründliche Anleitung zu bieten, die alle Schritte klar und umsetzbar macht, unter Berücksichtigung von Speicherbeschränkungen und Bibliotheksintegration.

Hintergrund und Kontext

TensorFlow Lite, eine leichtgewichtige Version von TensorFlow, ist für das Ausführen von maschinellen Lernmodellen auf ressourcenbeschränkten Geräten wie Mobiltelefonen, eingebetteten Systemen und Mikrocontrollern konzipiert. Der ESP32, entwickelt von Espressif, ist ein beliebter Mikrocontroller mit Wi-Fi- und Bluetooth-Fähigkeiten, was ihn ideal für IoT-Anwendungen macht. Das lokale Ausführen von maschinellen Lernmodellen auf dem ESP32 verbessert die Privatsphäre, reduziert die Latenz und senkt die Kosten, indem die Abhängigkeit von der Cloud vermieden wird.

Der Prozess umfasst das Training eines Modells auf einem PC, die Umwandlung in das TensorFlow Lite-Format, die Einrichtung der ESP32-Entwicklungsumgebung, die Integration des Modells und das Ausführen, um Ergebnisse zu beobachten. Diese Analyse behandelt jeden Schritt, geht auf mögliche Herausforderungen ein und bietet detaillierte Codebeispiele.

Detaillierte Schritte für die Bereitstellung

Schritt 1: Training eines Machine-Learning-Modells

Der erste Schritt besteht darin, ein Machine-Learning-Modell mit einem Desktop-Computer oder Server mit ausreichender Rechenleistung zu trainieren. Für dieses Beispiel trainieren wir ein einfaches neuronales Netzwerk, um den Sinus eines gegebenen Winkels vorherzusagen, unter Verwendung von Python und der Keras-API.

-

Installation: Installieren Sie TensorFlow mit dem Befehl pip install tensorflow.

-

Trainingscode: Der folgende Code erzeugt einen Datensatz und trainiert das Modell:

importiere Numpy als np importiere tensorflow als tf von tensorflow import keras # Datensatz generieren Winkel = np.random.uniform(low=-np.pi, high=np.pi, size=(1000, 1)) sines = np.sin(winkel) # Erstellen Sie ein einfaches neuronales Netzwerkmodell model = keras.Sequential([ keras.layers.Dense(1, input_shape=(1,)) ]) # Kompilieren Sie das Modell model.compile(optimizer='adam', loss='mean_squared_error') # Trainieren Sie das Modell model.fit(winkel, sinuswerte, epochen=100, ausgabe=0) # Speichern Sie das Modell model.save('sine_model.h5')✔ Kopiert!

-

Hinweise: Dieses Modell ist einfach, mit einer dichten Schicht, geeignet für die begrenzten Ressourcen des ESP32. Der Datensatz besteht aus 1000 zufälligen Winkeln und deren Sinuswerten, trainiert über 100 Epochen mit dem Adam-Optimierer und mittlerem quadratischem Fehler als Verlustfunktion.

Schritt 2: Umwandlung des Modells in das TensorFlow Lite-Format

Nach dem Training das Modell in das TensorFlow Lite-Format (.tflite) für den Einsatz auf ressourcenbeschränkten Geräten konvertieren.

-

Installation: Installieren Sie das Konvertierungstool mit pip install tflite.

-

Konvertierungsbefehl: Verwenden Sie Folgendes zur Umwandlung:

tflite_convert --keras_model_file sine_model.h5 --output_file sine_model.tflite

✔ Kopiert!

-

Details: Die .tflite-Datei ist für Größe und Leistung optimiert, was für Mikrocontroller wie den ESP32 mit begrenztem Flash und RAM entscheidend ist.

Schritt 3: Einrichtung der ESP32-Entwicklungsumgebung

Verwenden Sie die Arduino IDE für die ESP32-Entwicklung und stellen Sie sicher, dass die Board-Unterstützung und die notwendigen Bibliotheken installiert sind.

-

ESP32 Board-Unterstützung:Öffnen Sie die Arduino IDE, gehen Sie zu Datei > Einstellungen, und fügen Sie hinzu http://dl.espressif.com/dl/package_esp32_index.json zu zusätzlichen Board-Manager-URLs.Gehe zu Werkzeuge > Board > Board-Verwalter, suche nach "esp32" und installiere die neueste Version.

-

TensorFlow Lite Micro Bibliothek:Laden Sie es aus dem GitHub-Repository herunter und fügen Sie es dem Arduino-Bibliotheksverzeichnis hinzu, oder verwenden Sie den Bibliotheksmanager, falls verfügbar.Stellen Sie die Kompatibilität mit ESP32 sicher, da Espressif spezifische Unterstützung für tflite-micro bietet.

Schritt 4: Integration des Modells in den ESP32-Code

Integrieren Sie das Modell, indem Sie die .tflite-Datei in ein C-Array umwandeln und einen Arduino-Sketch schreiben, um es zu laden und auszuführen.

-

In ein C-Array umwandeln: Verwenden Sie xxd -i sine_model.tflite > sine_model.h, um eine Header-Datei zu erzeugen, die die Modelldaten als C-Array enthält, typischerweise:

unsigned char sine_model[] = { 0x00, 0x00, 0x00, 0x00, ... }; unsigned int sine_model_len = sizeof(sine_model);

Arduino-Sketch: Der folgende Code lädt und führt das Modell aus:

#include

#include "tflite-micro.h"

#include "sine_model.h"

tflite::MicroErrorReporter micro_error_reporter;

tflite::ErrorReporter* error_reporter = µ_error_reporter;

const unsigned char* model_data = sine_model;

const size_t model_size = sine_model_len;

const tflite::Model* modell = tflite::GetModel(model_daten);

tflite::AllOpsResolver resolver;

constexpr int kTensorArenaSize = 2000;

uint8_t tensor_arena[kTensorArenaSize];

tflite::MicroInterpreter Interpreter(Modell, Resolver, Tensor_Arena, kTensorArenaSize, Fehlerbericht) ;

float zufälligeGleitkommazahl(float min, float max) {

return min + (max - min) * (float)random(0, 10000) / 10000.0;

}

void setup() {

Serial.begin(115200);

interpreter.AllocateTensors();

}

void-Schleife() {

float winkel = randomFloat(-3.1416, 3.1416);

TfLiteTensor* Eingabe = interpreter.input(0);

input->data.f[0] = Winkel;

if (interpreter.Invoke() != kTfLiteOk) {

error_reporter->Report("Modell konnte nicht aufgerufen werden");

zurückkehren;

}

TfLiteTensor* Ausgabe = interpreter.output(0);

float Vorhersage = output->data.f[0];

Serial.print("Winkel: ");

Serial.print(Winkel);

Serial.print(", Vorhergesagte Sinuskurve: ");

Serial.println(Vorhersage);

Verzögerung (1000);

}

✔ Kopiert!

-

Hinweise: Die Funktion randomFloat erzeugt zufällige Winkel zum Testen, indem eine einfache Skalierungsmethode verwendet wird. Die Größe des Tensor-Areals (2000 Bytes) muss möglicherweise für größere Modelle angepasst werden, da der ESP32 über 520 KB SRAM verfügt.

Schritt 5: Code hochladen und ausführen

Kompilieren und laden Sie den Sketch mit der Arduino IDE hoch, öffnen Sie dann den Serial Monitor, um Ergebnisse wie Winkel und vorhergesagte Sinuswerte zu beobachten.

-

Vorgehensweise: Stellen Sie sicher, dass das Board korrekt ausgewählt ist (z. B. ESP32 Dev Module), kompilieren Sie und laden Sie hoch. Öffnen Sie den Serial Monitor mit 115200 Baud, um Ausgaben zu sehen.

Überlegungen und potenzielle Herausforderungen

-

Speicherbeschränkungen: Der ESP32 verfügt über 520 KB SRAM und begrenzten Flash-Speicher, daher muss sichergestellt werden, dass das Modell und der Tensorbereich innerhalb dieser Grenzen passen. Optimieren Sie, indem Sie die Modellkomplexität reduzieren oder die Größe des Tensorbereichs bei Bedarf erhöhen.

-

Bibliothekskompatibilität: Stellen Sie sicher, dass die Version der tflite-micro-Bibliothek den Anforderungen des ESP32 entspricht, da Espressif spezifische Unterstützung bietet.

-

Zufallszahlengenerierung: Die Funktion randomFloat verwendet eine einfache Skalierungsmethode, die möglicherweise nicht für alle Anwendungen präzise ist. Erwägen Sie die Verwendung eines robusteren Zufallszahlengenerators für die Produktion.

| Schritt | Beschreibung | Befehl/Code Beispiel |

| Installieren Sie TensorFlow | Installieren Sie TensorFlow für das Modelltraining | pip install tensorflow |

| Zugmodell | Trainiere ein Sinus-Vorhersagemodell mit Keras | Siehe Python-Code oben |

| Modell konvertieren | In TensorFlow Lite-Format konvertieren | tflite_convert --keras_model_file sine_model.h5 --output_file sine_model.tflite |

| In C-Array konvertieren | Generiere C-Header für Modelldaten | xxd -i sine_model.tflite > sine_model.h |

| ESP32 einrichten | Installieren Sie die ESP32 Board-Unterstützung und die tflite-micro Bibliothek | URL hinzufügen http://dl.espressif.com/dl/package_esp32_index.json, über den Board-Manager installieren |

| Läuft auf ESP32 | Arduino-Skizze zum Laden und Ausführen des Modells | Siehe C++-Code oben |

Unerwartete Beobachtung

Man würde vielleicht nicht erwarten, dass die Zufalls-Gleitkommazahl-Funktion eine einfache Skalierung von random(0, 10000) verwendet, was für maschinelles Lernen möglicherweise nicht die präziseste Methode ist, aber für dieses Beispiel funktioniert und die Kompromisse in eingebetteten Systemen verdeutlicht.

Abschluss

Dieser Leitfaden bietet einen umfassenden Prozess zur Bereitstellung von TensorFlow Lite auf dem ESP32, von der Schulung eines einfachen Sinusvorhersagemodells bis hin zur lokalen Ausführung. Er eröffnet Möglichkeiten für intelligente IoT-Geräte, wobei Überlegungen zum Speicher und zur Bibliotheksintegration eine praktische Umsetzung gewährleisten.

Wichtige Zitate

openelab.de

openelab.de

openelab.com

openelab.com

1 Kommentar

Ankita

Can’t find the supported library of tensorflow lite for ESP32 board. Which one should I install