Czym jest moduł M5Stack LLM?

Moduł M5Stack LLM to zintegrowany, offline Model Językowy Dużej Skali (LLM) przeznaczony do urządzeń końcowych wymagających efektywnej i inteligentnej interakcji. Niezależnie czy to dla inteligentnych domów, asystentów głosowych czy sterowania przemysłowego, Moduł LLM zapewnia płynne i naturalne doświadczenie AI bez konieczności korzystania z chmury, gwarantując prywatność i stabilność. Zintegrowany z frameworkiem StackFlow oraz bibliotekami Arduino/UiFlow, funkcje inteligentne można łatwo zaimplementować za pomocą zaledwie kilku linii kodu.

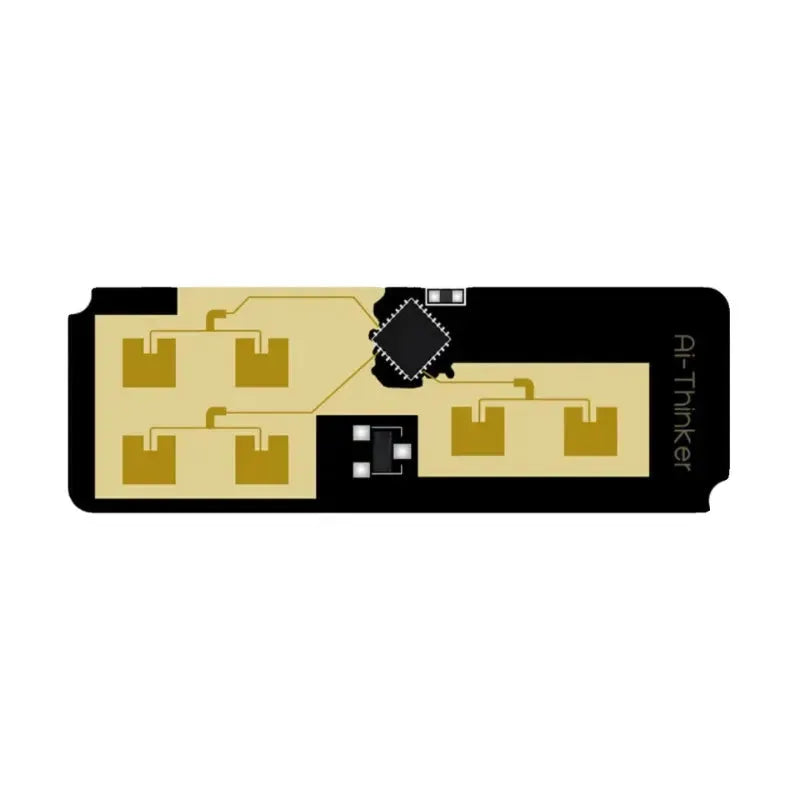

Zasilany zaawansowanym procesorem AX630C SoC, integruje 3,2 TOPs wysokowydajny NPU z natywnym wsparciem dla modeli Transformer, aby z łatwością radzić sobie ze skomplikowanymi zadaniami AI. Wyposażony w 4GB pamięci LPDDR4 (1GB dostępny dla aplikacji użytkownika, 3GB dedykowane do przyspieszenia sprzętowego) oraz 32GB pamięci eMMC, obsługuje równoległe ładowanie i sekwencyjne wnioskowanie wielu modeli dla płynnego wielozadaniowości. Główny chip jest produkowany w procesie 12nm firmy TSMC, z zużyciem energii operacyjnej około 1,5W, co czyni go wysoce wydajnym i odpowiednim do długotrwałej pracy.

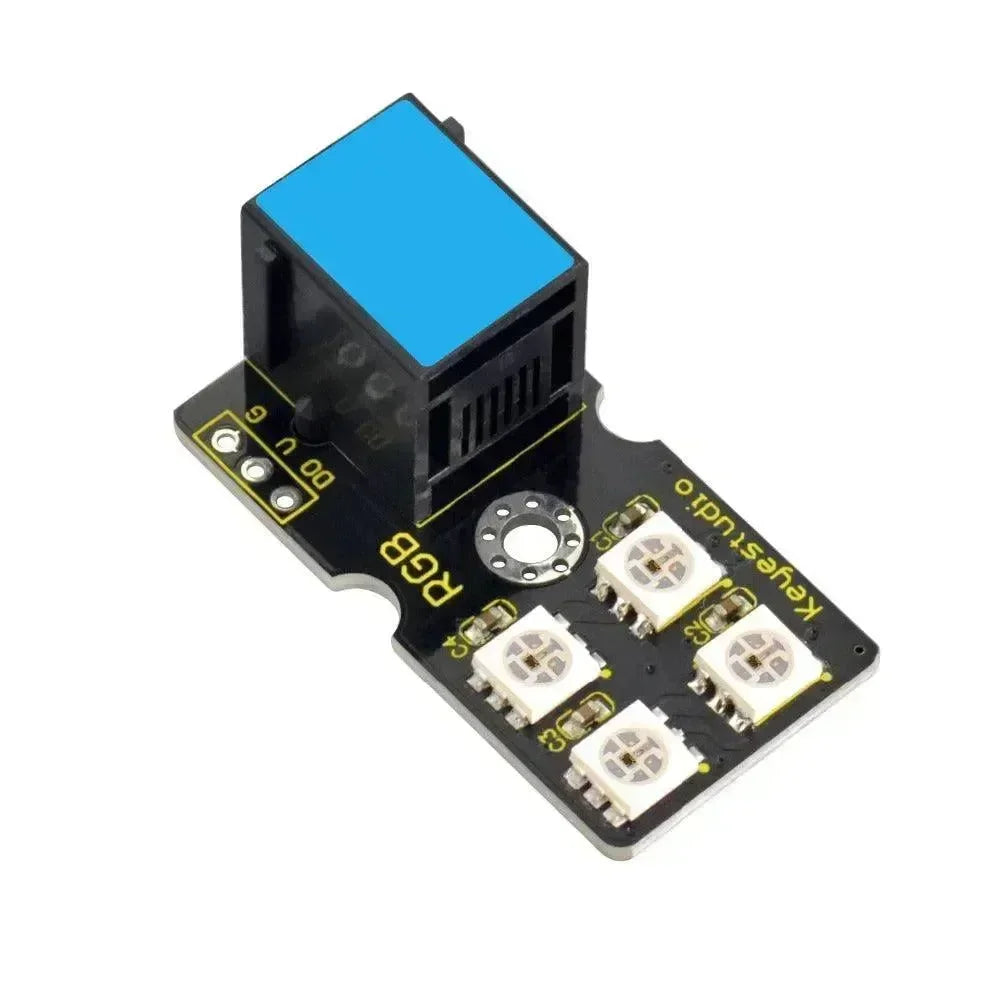

Posiada zintegrowany mikrofon, głośnik, kartę pamięci TF, USB OTG oraz podświetlenie statusu RGB, aby wspierać interakcję głosową i transfer danych dla szerokiego zakresu zastosowań. Moduł oferuje elastyczną rozbudowę: wbudowany slot na kartę SD obsługuje zimne/na gorąco aktualizacje oprogramowania układowego, a interfejs komunikacyjny UART upraszcza połączenie i debugowanie, zapewniając ciągłą optymalizację i rozbudowę funkcjonalności modułu. Port USB obsługuje automatyczne przełączanie master-slave, działając jako port debugowania oraz umożliwiając podłączenie dodatkowych urządzeń USB, takich jak kamery. Użytkownicy mogą zakupić zestaw do debugowania LLM, aby dodać port Ethernet 100Mbps oraz port szeregowy jądra, aby używać go jako SBC.

Przegląd

Sprzęt:

Mikrokontroler : Zazwyczaj wyposażony w AX630C@Dual Cortex A53 1.2 GHz MCU, który osiąga maks. 12,8 TOPS @INT4 oraz 3,2 TOPS @INT8.

Pamięć: 4GB LPDDR4 (1GB pamięci systemowej + 3GB dedykowane do przyspieszenia sprzętowego).

Pamięć: 32GB eMMC5.1

Port aktualizacji: karta SD / port Type-C

Funkcje

-

Wnioskowanie offline, moc obliczeniowa 3,2T przy precyzji INT8

-

Zintegrowane KWS (wykrywanie słowa wybudzającego), ASR (rozpoznawanie mowy), LLM (duży model językowy), TTS (generowanie mowy z tekstu)

-

Równoległe przetwarzanie wielomodelowe

-

Wbudowana pamięć eMMC 32GB i pamięć LPDDR4 4GB

-

Wbudowany mikrofon i głośnik

-

Komunikacja szeregowa

-

Aktualizacja oprogramowania układowego karty SD

-

Obsługuje debugowanie ADB

-

Wskaźnik świetlny RGB

-

Wbudowany system Ubuntu

-

Obsługuje funkcję OTG

-

Kompatybilny z Arduino/UIFlow

Użytkowanie i rozwój

-

Konfiguracja sprzętu:

-

Podłącz moduł LLM do swojego rdzenia M5Stack lub innego kompatybilnego urządzenia za pomocą portu Grove.

-

Upewnij się, że masz podłączoną antenę dla optymalnego zasięgu.

-

Tworzenie oprogramowania:

-

Zainstaluj bibliotekę LoRaWAN dla ESP32 w Arduino IDE lub użyj odpowiedniego oprogramowania układowego dla MicroPython, jeśli jest obsługiwane.

-

Skonfiguruj moduł za pomocą ustawień sieci LoRaWAN (np. DevEUI, AppEUI, AppKey).

-

Napisz kod do obsługi komunikacji LoRaWAN, w tym dołączania do sieci, wysyłania danych i odbierania poleceń.

-

Integracja z platformami IoT:

-

Wiele sieci LoRaWAN integruje się z platformami IoT, takimi jak The Things Network (TTN) lub komercyjni operatorzy sieci. Skonfiguruj swoje urządzenie do komunikacji z tymi platformami w celu zarządzania danymi i analityki.

Wniosek

Moduł M5Stack LLM jest kompatybilny z wieloma modelami i jest fabrycznie wyposażony w model mowy Qwen2.5-0.5B. Zapewnia funkcje KWS (wake word), ASR (automatyczne rozpoznawanie mowy), LLM (duży model językowy), oraz TTS (synteza mowy) , z obsługą samodzielnych wywołań lub automatycznego przekazywania w potoku dla ułatwienia rozwoju. Przyszłe wsparcie obejmuje modele Qwen2.5-1.5B, Llama3.2-1B oraz InternVL2-1B, umożliwiając gorące aktualizacje modeli, aby nadążać za trendami społeczności i realizować różnorodne złożone zadania AI. Możliwości wizji obejmują wsparcie dla CLIP, YoloWorld oraz przyszłe aktualizacje dla DepthAnything, SegmentAnything i innych zaawansowanych modeli, aby zwiększyć inteligentne wykrywanie i analizę.

Plug and play z hostami M5, moduł LLM zapewnia łatwe w użyciu doświadczenie interakcji z AI. Użytkownicy mogą szybko zintegrować go z istniejącymi inteligentnymi urządzeniami bez skomplikowanych ustawień, umożliwiając inteligentną funkcjonalność i zwiększając inteligencję urządzenia. Ten produkt jest odpowiedni dla asystentów głosowych offline, konwersji tekstu na mowę, sterowania inteligentnym domem, interaktywnych robotów i innych.

Jak korzystać z modułu M5Stack LLM?

Dziś pokażę Ci, jak używać M5Stack UIflow do testowania modułu M5Stack LLM (duży model językowy).

Sprzęt

Oprogramowanie

Nie wiesz, jak to zainstalować?

Arduino

Aktualizacja oprogramowania układowego

Ramowy program rozwoju

Zasoby rozwojowe

Polecane artykuły

openelab.de

openelab.de

openelab.com

openelab.com