Czym jest TensorFlow Lite?

TensorFlow Lite to lekka wersja TensorFlow, zaprojektowana dla urządzeń mobilnych i wbudowanych, takich jak ESP32, umożliwiająca uruchamianie modeli uczenia maszynowego na sprzęcie o ograniczonych zasobach.

Kroki do wdrożenia na ESP32

Oto jak uruchomić model uczenia maszynowego na twoim ESP32:

Trenuj model

Wytrenuj prostą sieć neuronową, na przykład do przewidywania wartości funkcji sinus, używając Pythona i Keras na swoim komputerze. Zainstaluj TensorFlow za pomocą:

-

Polecenie: pip install tensorflow

-

Przykładowy kod:

import numpy as np import tensorflow as tf z tensorflow importuj keras angles = np.random.uniform(low=-np.pi, high=np.pi, size=(1000, 1)) sines = np.sin(kąty) model = keras.Sequential([keras.layers.Dense(1, input_shape=(1,))]) model.compile(optimizer='adam', loss='mean_squared_error') model.fit(kąty, sinusy, epoki=100, verbose=0) model.save('sine_model.h5')✔ Skopiowano!

Konwertuj na TensorFlow Lite

Konwertuj wytrenowany model do formatu .tflite:

-

Zainstaluj narzędzie: pip install tflite

-

Konwertuj: tflite_convert --keras_model_file sine_model.h5 --output_file sine_model.tflite

Skonfiguruj ESP32

Użyj Arduino IDE do rozwoju ESP32. Zainstaluj wsparcie dla ESP32:

-

Dodaj URL: http://dl.espressif.com/dl/package_esp32_index.json w Preferencjach.

-

Zainstaluj przez Menedżera Płytek.

-

Dodaj bibliotekę tflite-micro z repozytorium GitHub do bibliotek Arduino.

Integruj i uruchom

Konwertuj .tflite na tablicę C: xxd -i sine_model.tflite > sine_model.h. Użyj tego szkicu Arduino:

-

Kod:

#include #include "tflite-micro.h" #include "sine_model.h" tflite::MicroErrorReporter mikro_raportujący_błędy; tflite::ErrorReporter* error_reporter = µ_error_reporter; const unsigned char* model_data = sine_model; const size_t model_size = sine_model_len; const tflite::Model* model = tflite::GetModel(model_data); tflite::AllOpsResolver rozwiązywacz; constexpr int kTensorArenaSize = 2000; uint8_t tensor_arena[kTensorArenaSize]; tflite::MicroInterpreter interpreter(model, resolver, tensor_arena, kTensorArenaSize, error_reporter); float losowaLiczbaZmiennoprzecinkowa(float min, float max) { return min + (max - min) * (float)random(0, 10000) / 10000.0; } void setup() { Serial.begin(115200); interpreter.AllocateTensors(); } void loop() { float angle = randomFloat(-3.1416, 3.1416); TfLiteTensor* input = interpreter.input(0); input->data.f[0] = angle; jeśli (interpreter.Invoke() != kTfLiteOk) { error_reporter->Report("Nie udało się wywołać modelu"); return; } TfLiteTensor* output = interpreter.output(0); float prediction = output->data.f[0]; Serial.print("Kąt: "); Serial.print(kąt); Serial.print(", Przewidywana sinusoida: "); Serial.println(prediction); opóźnienie(1000); }✔ Skopiowano!

-

Prześlij do ESP32, otwórz Monitor Szeregowy, aby zobaczyć wyniki.

Nieoczekiwany szczegół

Możesz nie spodziewać się, że funkcja losowej liczby zmiennoprzecinkowej używa prostego skalowania random(0, 10000), co może nie być najdokładniejsze dla ML, ale działa w tym przykładzie.

Wdrażanie TensorFlow Lite na ESP32

Ta kompleksowa analiza bada wdrażanie TensorFlow Lite na mikrokontrolerze ESP32, szczegółowo opisując proces od trenowania modelu do jego wykonania, opierając się na badaniach i praktycznej implementacji. Skupia się na dostarczeniu szczegółowego przewodnika dla programistów, zapewniając, że wszystkie kroki są jasne i wykonalne, z uwzględnieniem ograniczeń pamięci i integracji bibliotek.

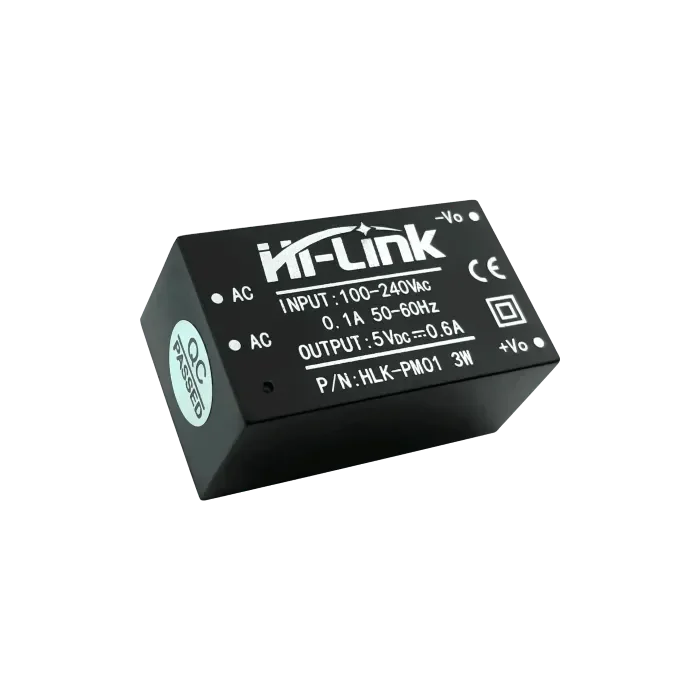

Tło i kontekst

TensorFlow Lite, lekka wersja TensorFlow, jest zaprojektowana do uruchamiania modeli uczenia maszynowego na urządzeniach o ograniczonych zasobach, takich jak telefony komórkowe, systemy wbudowane i mikrokontrolery. ESP32, opracowany przez Espressif, to popularny mikrokontroler z funkcjami Wi-Fi i Bluetooth, co czyni go idealnym do zastosowań IoT. Uruchamianie modeli uczenia maszynowego lokalnie na ESP32 zwiększa prywatność, zmniejsza opóźnienia i obniża koszty, unikając zależności od chmury.

Proces obejmuje trenowanie modelu na komputerze PC, konwersję do formatu TensorFlow Lite, konfigurację środowiska programistycznego ESP32, integrację modelu oraz uruchomienie go w celu obserwacji wyników. Ta analiza obejmuje każdy krok, omawiając potencjalne wyzwania i dostarczając szczegółowe przykłady kodu.

Szczegółowe kroki wdrożenia

Krok 1: Trenowanie modelu uczenia maszynowego

Pierwszym krokiem jest wytrenowanie modelu uczenia maszynowego przy użyciu komputera stacjonarnego lub serwera o wystarczającej mocy obliczeniowej. W tym przykładzie trenujemy prostą sieć neuronową do przewidywania wartości sinusa dla danego kąta, korzystając z Pythona i API Keras.

-

Instalacja: Zainstaluj TensorFlow za pomocą polecenia pip install tensorflow.

-

Kod szkoleniowy: Poniższy kod generuje zestaw danych i trenuje model:

import numpy as np import tensorflow as tf z tensorflow importuj keras # Generuj zestaw danych angles = np.random.uniform(low=-np.pi, high=np.pi, size=(1000, 1)) sines = np.sin(kąty) # Utwórz prosty model sieci neuronowej model = keras.Sequential([ keras.layers.Dense(1, input_shape=(1,)) ]) # Kompiluj model model.compile(optimizer='adam', loss='mean_squared_error') # Trenuj model model.fit(kąty, sinusy, epoki=100, verbose=0) # Zapisz model model.save('sine_model.h5')✔ Skopiowano!

-

Uwagi: Ten model jest prosty, z jedną gęstą warstwą, odpowiedni dla ograniczonych zasobów ESP32. Zbiór danych składa się z 1000 losowych kątów i ich wartości sinusów, trenowany przez 100 epok z optymalizatorem Adam i stratą średniego błędu kwadratowego.

Krok 2: Konwersja modelu do formatu TensorFlow Lite

Po treningu, przekonwertuj model do formatu TensorFlow Lite (.tflite) w celu wdrożenia na urządzeniach o ograniczonych zasobach.

-

Instalacja: Zainstaluj narzędzie konwersji za pomocą pip install tflite.

-

Polecenie konwersji: Użyj następującego do konwersji:

tflite_convert --keras_model_file sine_model.h5 --output_file sine_model.tflite

✔ Skopiowano!

-

Szczegóły: Plik .tflite jest zoptymalizowany pod kątem rozmiaru i wydajności, co jest kluczowe dla mikrokontrolerów takich jak ESP32 z ograniczoną pamięcią flash i RAM.

Krok 3: Konfigurowanie środowiska programistycznego ESP32

Użyj Arduino IDE do rozwoju ESP32, upewniając się, że wsparcie dla płytek i niezbędne biblioteki są zainstalowane.

-

Wsparcie płyty ESP32:Otwórz Arduino IDE, przejdź do Plik > Preferencje i dodaj http://dl.espressif.com/dl/package_esp32_index.json do dodatkowych adresów URL Menedżera Płyt.Przejdź do Narzędzia > Płytka > Menedżer płytek, wyszukaj "esp32" i zainstaluj najnowszą wersję.

-

Biblioteka TensorFlow Lite Micro:Pobierz z repozytorium GitHub i dodaj do katalogu bibliotek Arduino, lub użyj Menedżera Bibliotek, jeśli jest dostępny.Zapewnij kompatybilność z ESP32, ponieważ Espressif oferuje specjalne wsparcie dla tflite-micro.

Krok 4: Integracja modelu z kodem ESP32

Zintegruj model, konwertując plik .tflite na tablicę C i pisząc szkic Arduino do jego załadowania i uruchomienia.

-

Konwertuj na tablicę C: Użyj xxd -i sine_model.tflite > sine_model.h, aby wygenerować plik nagłówkowy zawierający dane modelu jako tablicę C, zazwyczaj:

unsigned char sine_model[] = { 0x00, 0x00, 0x00, 0x00, ... }; unsigned int sine_model_len = sizeof(sine_model);

Szkic Arduino: Następujący kod ładuje i uruchamia model:

#include

#include "tflite-micro.h"

#include "sine_model.h"

tflite::MicroErrorReporter mikro_raportujący_błędy;

tflite::ErrorReporter* error_reporter = µ_error_reporter;

const unsigned char* model_data = sine_model;

const size_t model_size = sine_model_len;

const tflite::Model* model = tflite::GetModel(model_data);

tflite::AllOpsResolver rozwiązywacz;

constexpr int kTensorArenaSize = 2000;

uint8_t tensor_arena[kTensorArenaSize];

tflite::MicroInterpreter interpreter(model, resolver, tensor_arena, kTensorArenaSize, error_reporter);

float losowaLiczbaZmiennoprzecinkowa(float min, float max) {

return min + (max - min) * (float)random(0, 10000) / 10000.0;

}

void setup() {

Serial.begin(115200);

interpreter.AllocateTensors();

}

void loop() {

float angle = randomFloat(-3.1416, 3.1416);

TfLiteTensor* input = interpreter.input(0);

input->data.f[0] = angle;

jeśli (interpreter.Invoke() != kTfLiteOk) {

error_reporter->Report("Nie udało się wywołać modelu");

return;

}

TfLiteTensor* output = interpreter.output(0);

float prediction = output->data.f[0];

Serial.print("Kąt: ");

Serial.print(kąt);

Serial.print(", Przewidywana sinusoida: ");

Serial.println(prediction);

opóźnienie(1000);

}

✔ Skopiowano!

-

Uwagi: Funkcja randomFloat generuje losowe kąty do testów, używając prostej metody skalowania. Rozmiar obszaru tensorowego (2000 bajtów) może wymagać dostosowania dla większych modeli, biorąc pod uwagę 520 KB SRAM ESP32.

Krok 5: Prześlij i uruchom kod

Skompiluj i załaduj szkic za pomocą Arduino IDE, a następnie otwórz Monitor Szeregowy, aby obserwować wyniki, takie jak kąty i przewidywane wartości sinusa.

-

Procedura: Upewnij się, że wybrana jest odpowiednia płytka (np. ESP32 Dev Module), skompiluj i wgraj. Otwórz Monitor Szeregowy z prędkością 115200 bodów, aby zobaczyć wyniki.

Rozważania i potencjalne wyzwania

-

Ograniczenia pamięci: ESP32 ma 520 KB SRAM i ograniczoną pamięć flash, więc upewnij się, że model i arena tensorów mieszczą się w tych limitach. Optymalizuj, zmniejszając złożoność modelu lub zwiększając rozmiar areny tensorów, jeśli to konieczne.

-

Kompatybilność biblioteki: Upewnij się, że wersja biblioteki tflite-micro odpowiada wymaganiom ESP32, ponieważ Espressif zapewnia specyficzne wsparcie.

-

Generowanie liczb losowych: funkcja randomFloat używa prostej metody skalowania, która może nie być precyzyjna dla wszystkich zastosowań. Rozważ użycie bardziej zaawansowanego generatora liczb losowych do produkcji.

| Krok | Opis | Przykład polecenia/kodu |

| Zainstaluj TensorFlow | Zainstaluj TensorFlow do trenowania modelu | pip install tensorflow |

| Trenuj model | Trenuj model predykcji sinusoidalnej za pomocą Keras | Zobacz powyższy kod Pythona |

| Konwertuj model | Konwertuj do formatu TensorFlow Lite | tflite_convert --keras_model_file sine_model.h5 --output_file sine_model.tflite |

| Konwertuj na tablicę C | Generuj nagłówek C dla danych modelu | xxd -i sine_model.tflite > sine_model.h |

| Skonfiguruj ESP32 | Zainstaluj wsparcie płyty ESP32 oraz bibliotekę tflite-micro | Dodaj URL http://dl.espressif.com/dl/package_esp32_index.json, zainstaluj przez Menedżera Płytek |

| Uruchom na ESP32 | Szkic Arduino do ładowania i wykonywania modelu | Zobacz powyższy kod C++ |

Nieoczekiwana obserwacja

Możesz nie spodziewać się, że funkcja losowej liczby zmiennoprzecinkowej używa prostego skalowania random(0, 10000), co może nie być najdokładniejsze dla uczenia maszynowego, ale działa w tym przykładzie, podkreślając kompromisy w systemach wbudowanych.

Wniosek

Ten przewodnik przedstawia kompleksowy proces wdrażania TensorFlow Lite na ESP32, od trenowania prostego modelu predykcji sinusoidy po jego lokalne uruchomienie. Otwiera możliwości dla inteligentnych urządzeń IoT, z uwzględnieniem pamięci i integracji bibliotek zapewniając praktyczną implementację.

Kluczowe cytowania

openelab.de

openelab.de

openelab.com

openelab.com

1 komentarz

Ankita

Can’t find the supported library of tensorflow lite for ESP32 board. Which one should I install